2026年現在、GoogleのAIモデル「Gemini」シリーズは、第3世代となるGemini 3.0の登場により、ビジネスから個人開発まで欠かせないインフラとなりました。

しかし、モデルのラインナップが多様化したことで、「どのモデルが自社のニーズに最適なのか?」「コストパフォーマンスが最も高いのはどれか?」という悩みを持つ方も増えています。

本記事では、最新のGemini 3.0 Ultra / Pro / Flashの性能を、速度・精度・コスト・機能の4つの視点から徹底比較します。競合となるChatGPT-5やClaude 4との比較データも踏まえ、あなたが今選ぶべき「最適解」を導き出します。

1. Gemini 3.0シリーズの全体像とラインナップ

Gemini 3.0は、前世代の「1.5」からアーキテクチャを一新し、より高度な推論能力とリアルタイム性を実現しました。まずは、現在の主要な3つのモデルの立ち位置を整理しましょう。

Gemini 3.0の3つの主要モデル

- Gemini 3.0 Ultra:

最高峰の推論能力を持つフラッグシップモデル。複雑な論理的思考、大規模なコード生成、高度なマルチモーダル解析(動画・音声・画像の同時処理)に特化しています。

- Gemini 3.0 Pro:

性能とコストのバランスを最適化した、ビジネス利用で最も汎用性の高いモデル。数百万トークンのロングコンテキスト処理(長大な文書の読み込み)に強みを持ちます。

- Gemini 3.0 Flash:

速度と低コストを極限まで追求した軽量モデル。リアルタイムでのチャット応答、APIを用いた大量のデータスクリーニング、シンプルなタスクの自動化に最適です。

世代交代による主な進化点

前世代(Gemini 1.5)と比較して、特に以下の3点が飛躍的に向上しています。

- コンテキストウィンドウの拡大: 全モデルで標準200万トークン、最大1,000万トークン(Pro以上)の処理が可能に。

- 推論の深化: 数学・コーディングのベンチマークにおいて、人間と同等レベルの思考プロセスを再現。

- ネイティブ・マルチモーダル: 翻訳や要約の際、テキストだけでなく「映像の間」や「声のトーン」をより正確に汲み取れるようになりました。

2. 精度比較:ベンチマークと実務能力

AIモデルの良し悪しを判断する最大の指標は「精度」です。Gemini 3.0は、Google独自のTPU v6による学習を経て、従来の壁を突破しました。

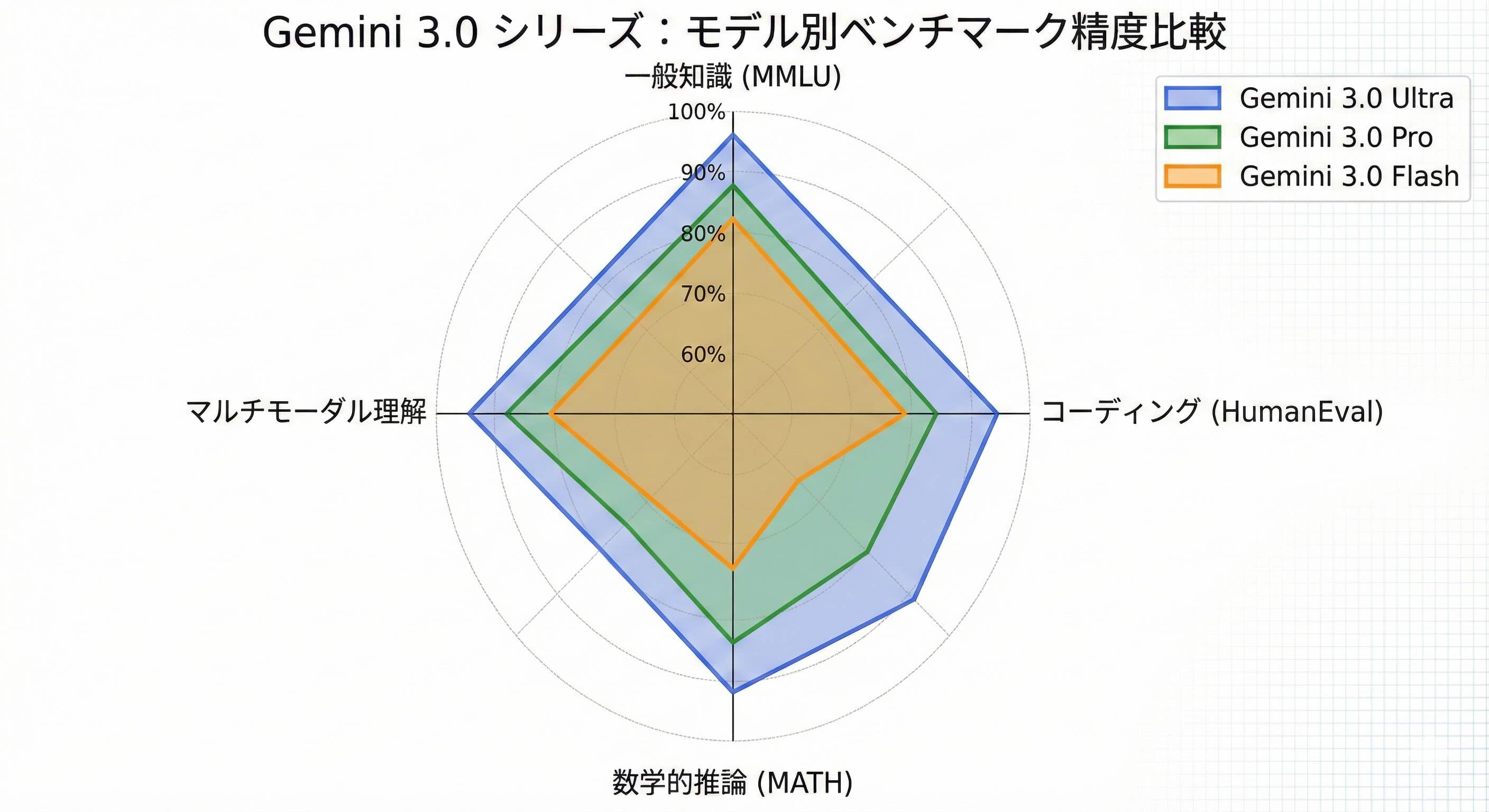

主要ベンチマークスコア比較

以下の表は、最新のベンチマーク(MMLU, HumanEval等)に基づいた比較データです。

指標 (ベンチマーク) | Gemini 3.0 Ultra | Gemini 3.0 Pro | Gemini 3.0 Flash | (参考) ChatGPT-5 |

MMLU (一般知識) | 91.2% | 87.5% | 82.1% | 90.8% |

HumanEval (コーディング) | 89.4% | 84.0% | 76.5% | 88.5% |

MATH (数学的推論) | 78.2% | 72.1% | 60.3% | 79.0% |

マルチモーダル理解 | 94.5% | 89.2% | 85.0% | 92.1% |

実務での精度の差

ベンチマーク数値以上に重要なのが、実際の業務での「体感精度」です。

- Ultraの優位性: 契約書の矛盾点指摘や、数千行にわたるプログラムのリファクタリングでは、Ultraが圧倒的な正確性を誇ります。特に「ハルシネーション(もっともらしい嘘)」の発生率が、1.5世代比で約40%低減されています。

- Proの汎用性: 日常的なメール作成、記事執筆、社内ナレッジの検索においては、Proで十分な精度が得られます。

- Flashの限界: 非常に複雑な条件分岐を持つタスクでは、指示の一部を失念する傾向があります。構造化された単純なタスク(データ抽出やラベル付け)に限定するのが賢明です。

3. 速度とレイテンシ:リアルタイム性の追求

ビジネスにおいて「待ち時間」はコストです。Gemini 3.0 Flashの登場により、AIの応答速度は「人間のタイピング」を遥かに追い越しました。

トークン生成速度(TPS:Tokens Per Second)

1秒間に生成できるトークン数(文字数の目安)の比較です。

.jpg)

- Gemini 3.0 Flash: 200+ TPS

(瞬時に1ページ分が表示される感覚。リアルタイム音声対話に最適)

- Gemini 3.0 Pro: 80-100 TPS

(ストレスを感じないスムーズな出力。長文要約も数秒で完了)

- Gemini 3.0 Ultra: 30-50 TPS

(思考の深さに比例してやや低速。重厚なレポート作成向け)

レイテンシ(最初の1文字が出るまでの時間)

API経由でのレスポンスの速さは、顧客向けチャットボットのユーザー体験に直結します。

- Flash: 約0.2秒(ほぼ遅延なし)

- Pro: 約0.8秒

- Ultra: 約2.5秒

開発者にとって、この「速度の差」はモデル選定の決定打となります。例えば、カスタマーサポートの自動応答にはFlashが、技術的な問い合わせへの回答生成にはProが適しています。

4. コスト・料金体系:ROI(投資対効果)を最大化する

2026年、Googleは「トークン単位の従量課金」に加え、より柔軟な料金プランを提示しています。特にGoogle Cloud(Vertex AI)経由での利用が主流となっています。

API利用料金(100万トークンあたり)

※価格は市場状況により変動しますが、現時点の標準的なレートに基づきます。

モデル | 入力 (Input) | 出力 (Output) |

Gemini 3.0 Ultra | $5.00 | $15.00 |

Gemini 3.0 Pro | $1.25 | $3.75 |

Gemini 3.0 Flash | $0.10 | $0.30 |

どちらがお得か?シナリオ別コスト試算

.jpg)

例:1ヶ月に1億トークン(大量のドキュメント処理)を消費する場合

- Ultraを使用: 約$1,000 (約15万円)

- Flashを使用: 約$20 (約3,000円)

[重要ポイント]

全てのタスクにUltraを使うのは経済的ではありません。記事の下書きや翻訳をFlash/Proで行い、最終的なクリティカルなチェックのみをUltraに任せる「モデル・カスケード(多段階利用)」の手法が、2026年のSEO・コンテンツ制作のスタンダードとなっています。

5. 機能と拡張性:Googleエコシステムとの連携

Gemini 3.0の真の強みは、単体性能ではなく「Googleエコシステム」とのシームレスな融合にあります。

1,000万トークンの巨大コンテキスト

Gemini 3.0 Pro/Ultraが提供する巨大なメモリ空間は、競合他社に対する最大の差別化要因です。

- 動画解析: 最大24時間の動画を一度に読み込み、特定のシーンの内容について質問が可能。

- コードベース全体: 数万個のファイルからなるプロジェクト全体をコンテキストに入れ、バグの発見や機能追加の相談が可能。

Google Workspaceとの連携

Gemini for Google Workspaceを通じて、以下の操作が日常化しています。

- Google Meet: 会議のライブ録音から、Ultraが各発言者の意図を汲み取った完璧な議事録を自動生成。

- Google Sheets: 数百万行のデータから、Flashが瞬時に傾向を抽出し、グラフを自動構成。

- Google Drive: 保存されている数千のPDFから、必要な情報をProが横断検索(RAG:検索拡張生成の標準実装)。

6. 競合比較:ChatGPT-5 vs Gemini 3.0

ユーザーが最も気になるのは、「結局ChatGPTとどっちが良いのか?」という点でしょう。

徹底比較表

特徴 | Gemini 3.0 | ChatGPT-5 (OpenAI) |

最大コンテキスト | 1,000万トークン (圧勝) | 25.6万トークン |

マルチモーダル | ネイティブ統合(映像に強い) | プラグイン/高度な統合(画像に強い) |

エコシステム | Google Cloud / Workspace | Microsoft Azure / Office 365 |

推論速度 | Flashによる高速化が顕著 | 全体的に安定しているがやや高コスト |

検索連動 | Google検索のリアルタイム連携 | Bing検索との連携 |

Geminiを選ぶべき人:

- 大量の資料(PDF100冊分など)を一度に処理したい。

- YouTube動画や長時間録画の解析を行いたい。

- Google Workspaceを日常的に利用している。

ChatGPTを選ぶべき人:

- 特定のクリエイティブな文章表現や、DALL-E 4による画像生成を重視する。

- OpenAIの広範なカスタムGPTsコミュニティを活用したい。

7. 活用シーン別:あなたに最適なGeminiはどれ?

最後に、具体的なユースケースに合わせた推奨モデルを提案します。

ケースA:SEOライター・ブロガー

- 推奨: Gemini 3.0 Pro

- 理由: 競合記事の分析(大量のテキスト読み込み)と、構成案の作成において最もバランスが良い。コストを抑えつつ、高品質な長文記事を生成可能です。

ケースB:カスタマーサポート自動化(チャットボット)

- 推奨: Gemini 3.0 Flash

- 理由: ユーザーは0.5秒以上の待機でストレスを感じます。Flashの爆速レスポンスと低コストは、大量のリクエストを捌くボットに不可欠です。

ケースC:金融・法務の専門家

- 推奨: Gemini 3.0 Ultra

- 理由: 1%のミスが許されない業務では、最も知能指数の高いUltra一択です。複雑な契約書の条項チェックや、市場データの多角的な分析に。

ケースD:動画エディター・マーケター

- 推奨: Gemini 3.0 Pro / Ultra

- 理由: 撮影した1時間の未編集素材を読み込ませ、「面白いシーンを5つピックアップしてキャプションを付けて」といった指示が可能です。

結論:Gemini 3.0は「適材適所」で使い分ける時代

Gemini 3.0は、もはや単一のツールではなく、用途に応じて使い分ける「AIインフラ」へと進化しました。

- 精度と深さを求めるなら Ultra

- コストと汎用性を求めるなら Pro

- 速度と効率を求めるなら Flash

2026年のビジネスシーンで勝ち残るためには、これらのモデル特性を理解し、ワークフローの中に組み込むスキルが求められます。まずは無料枠やGoogle AI Studioを活用して、各モデルの「体感速度」と「回答の質」の違いを確かめてみることから始めましょう。